如何分析蜘蛛抓取网站的频率?哪些因素影响蜘蛛抓取频率?

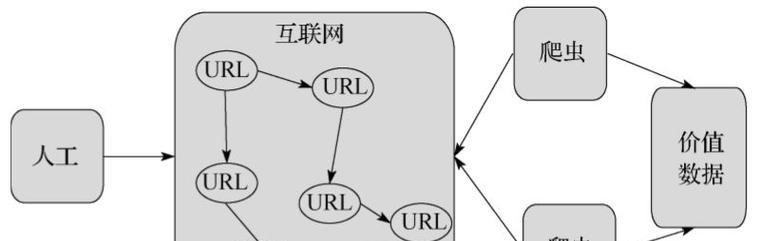

在互联网搜索引擎优化(SEO)领域,蜘蛛(或称为爬虫、爬行器)的抓取行为至关重要,因为它直接影响着网站内容在搜索引擎中的可见度和排名。蜘蛛抓取网站的频率是衡量网站被搜索引擎重视程度的重要指标之一,分析蜘蛛抓取网站的频率对于网站所有者来说显得尤为重要。以下我们将从几个方面深入分析蜘蛛抓取网站频率的要素,并提供实际操作指导。

一、网站内容更新频率

蜘蛛非常喜欢新鲜、独特的内容。网站内容更新的频率是影响蜘蛛抓取频率的重要因素。经常更新网站内容的网站能够吸引蜘蛛更频繁地访问,从而提高抓取频率。而内容更新不仅指数量的增加,更包括质量的提升。以下是提高内容更新频率的几个建议:

1.设立博客栏目:定期发表原创文章,与行业动态、用户需求相结合,提供有价值的信息。

2.产品/服务页面更新:对于电子商务或服务类网站,定期更新产品信息或服务介绍,增加新功能或服务亮点。

3.新闻和公告:发布公司新闻、行业新闻或相关公告,保持页面内容的实时性和动态性。

二、网站结构与导航设计

一个清晰、合理、易于爬行的网站结构对于蜘蛛抓取至关重要。蜘蛛通过网站的链接结构来发现和索引页面,如果链接结构设计得当,蜘蛛抓取的效率和频率自然会提高。以下几点建议能帮助优化网站结构:

1.扁平化结构:尽量减少页面之间的跳转层级,让蜘蛛能够通过较少的点击到达所有页面。

2.面包屑导航:在页面上提供清晰的面包屑导航,帮助蜘蛛和用户理解当前位置。

3.内部链接策略:合理布置内部链接,特别是在内容丰富且重要的页面上,设置指向其他相关页面的链接,方便蜘蛛抓取。

三、Sitemap的提交与维护

Sitemap(站点地图)是网站所有页面的列表,它帮助搜索引擎了解网站的结构,并指导蜘蛛抓取。提交Sitemap到搜索引擎,例如百度站长平台,能有效地通知蜘蛛哪些页面需要被抓取或重新抓取。定期更新和维护Sitemap是提高蜘蛛抓取频率的有效手段:

1.生成Sitemap:使用工具或插件自动生成网站的Sitemap文件。

2.提交Sitemap:将Sitemap文件提交到百度站长平台,以及其他重要的搜索引擎。

3.定期更新:每当网站有新的内容更新或页面变更时,都应及时更新Sitemap并重新提交。

四、服务器响应速度和稳定性

服务器的响应速度和稳定性是决定蜘蛛抓取频率的又一关键因素。如果服务器响应缓慢或频繁出现故障,蜘蛛在抓取过程中可能会遇到困难,甚至放弃索引。以下几点应引起网站管理员的重视:

1.选择可靠的服务提供商:确保服务器提供商的可靠性,避免选择经常出现故障的服务商。

2.优化网站代码:对网站进行代码优化,减少不必要的重载和复杂操作,提高页面加载速度。

3.使用CDN加速:内容分发网络(CDN)能有效提高网站加载速度,尤其在不同地域的用户访问时。

4.监控网站状态:定期检查服务器日志,确保网站运行稳定,无异常错误记录。

五、网站质量与用户体验

蜘蛛抓取的最终目的是为了提供更优质的搜索结果给用户。网站的质量和用户体验直接影响蜘蛛抓取的频率。高质量的网站通常具有以下特点:

1.良好的用户互动:如评论、分享、点赞等,能够吸引用户停留和互动的元素,会增加蜘蛛抓取的频率。

2.页面布局和设计:清晰、直观的页面布局和美观的设计能够提高用户停留时间,从而间接影响蜘蛛的抓取频率。

3.移动端适配:随着移动设备的普及,网站的移动端适配程度也变得尤为重要。良好的移动端体验将有助于提升蜘蛛抓取频率。

六、外部链接与网站权重

外部链接的质量和数量对蜘蛛抓取频率也有重要影响。外部链接相当于对网站的一个“投票”,高质量的外部链接能够提升网站的权重,增加蜘蛛抓取的频率。以下是一些提升外部链接质量的方法:

1.建立高质量友情链接:与其他高权重、相关性强的网站进行友情链接交换。

2.内容营销:通过撰写高质量的原创内容,吸引其他网站或博客进行引用或转载。

3.社交媒体推广:在社交媒体上积极推广网站内容,增加内容的曝光率,吸引外部链接。

七、蜘蛛抓取工具与数据分析

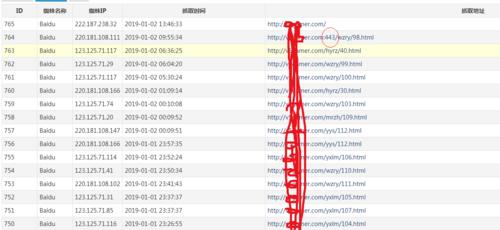

使用专业的SEO工具来监控蜘蛛抓取行为,是分析蜘蛛抓取频率的有效手段。通过对抓取日志的分析,可以了解蜘蛛访问网站的模式和频率,发现并解决可能存在的问题。以下是一些常用的方法和工具:

1.使用百度站长工具:通过百度站长平台提供的抓取诊断工具,可以查看蜘蛛抓取的状态码和响应时间。

2.分析服务器日志:定期分析服务器日志文件,了解蜘蛛的抓取行为和抓取规律。

3.监控404错误页面:监控404页面的产生情况,及时修正错误链接,避免蜘蛛在抓取时出现大量无效链接。

八、常见问题及解决方案

在分析蜘蛛抓取频率的过程中,我们可能会遇到一些常见问题。以下列出了一些问题及其相应的解决方案:

1.蜘蛛抓取频率低:检查网站内容更新频率、服务器响应速度、外部链接质量,并采取相应措施进行优化。

2.抓取错误代码较多:分析蜘蛛返回的错误代码,如404、503等,并进行针对性的解决。

3.网站内容被错误索引:使用robots.txt文件明确指示蜘蛛哪些内容可以抓取,哪些不可抓取。

结语

通过以上几方面的分析和优化,我们可以有效地提高蜘蛛抓取网站的频率,进而提升网站在搜索引擎中的表现。值得注意的是,这些操作并非一蹴而就,而是需要持续地监控、分析和调整,以应对搜索引擎算法的更新和网站自身的变化。综合以上分析,我们可以得出结论:网站内容更新、结构设计、Sitemap维护、服务器质量、网站质量、外部链接建设、监控分析工具的运用,以及对常见问题的及时解决,都是提高蜘蛛抓取频率的关键。只有对这些方面进行综合考量和策略部署,网站才能在搜索引擎中获得更好的曝光和排名。